1 Interpretazione bayesiana della probabilità

Introduzione

In questo capitolo esploreremo la probabilità da una prospettiva bayesiana, concependola fin dall’inizio come un grado di credenza razionale piuttosto che come una proprietà fisica degli eventi o una frequenza limite. Questa visione, profondamente radicata nei lavori di Thomas Bayes, Pierre-Simon Laplace e Bruno de Finetti, offre una base concettualmente coerente per affrontare l’incertezza nella ricerca psicologica.

Scopriremo che gli assiomi della probabilità non sono “leggi naturali” della casualità, ma vincoli di coerenza logica tra le nostre credenze. Quando violiamo questi vincoli, le nostre assegnazioni di probabilità diventano contraddittorie e ci espongono a situazioni paradossali (il famoso “Dutch Book”). Le simulazioni al computer, che utilizzeremo ampiamente, non definiranno cosa sia la probabilità, ma illustreranno come credenze coerenti si comportano quando vengono verificate empiricamente.

Panoramica del capitolo

- La probabilità come grado di credenza razionale.

- Incertezza epistemica e ontologica.

- L’argomento della coerenza: Dutch Book e scommesse eque.

- Cenni storici alla tradizione bayesiana.

- Simulazioni come strumento di verifica (non di definizione).

1.1 Casualità e incertezza

La vita è intrinsecamente incerta: non possiamo conoscere con precisione il passato, prevedere il futuro né comprendere appieno la complessità del presente. Come sottolinea David Spiegelhalter, in un recente articolo pubblicato su Nature, questa condizione di ignoranza ci spinge a interpretare la casualità come un modello utile, che pur non offrendo certezze deterministiche, rivela preziose regolarità statistiche (Spiegelhalter, 2024).

Per navigare questa incertezza, è cruciale distinguere tra due concezioni fondamentali della probabilità:

- Visione ontologica: la probabilità come proprietà intrinseca del mondo fisico (ad esempio, “Questa moneta ha probabilità 0.5 di mostrare testa.”).

- Visione epistemica: la probabilità come misura della nostra ignoranza e grado di credenza razionale (ad esempio, “In base alle informazioni disponibili, assegno probabilità 0.5 all’uscita di testa.”).

In questo corso adotteremo sistematicamente la prospettiva epistemica, che considera la probabilità non come una caratteristica del mondo, ma come uno strumento per quantificare coerentemente la nostra incertezza alla luce delle informazioni di cui disponiamo.

1.2 Due dimensioni dell’incertezza: epistemica e ontologica

L’incertezza che incontriamo nell’analisi dei fenomeni complessi si manifesta secondo due dimensioni distinte, che riflettono le due visioni della probabilità appena presentate.

Incertezza epistemica

Dipende dai limiti della nostra conoscenza o dai dati a disposizione. Se in un esperimento non si controllano adeguatamente variabili importanti o disponiamo di campioni insufficienti, la nostra valutazione probabilistica risente di queste carenze informative. Questo tipo di incertezza può essere ridotto migliorando il disegno sperimentale, aumentando le osservazioni o acquisendo nuove conoscenze.Incertezza ontologica

È insita nella natura stessa del fenomeno studiato e persiste indipendentemente dalla precisione delle nostre misurazioni. Il risultato di un lancio di dadi rimane fondamentalmente imprevedibile nel caso singolo, anche disponendo di informazioni dettagliate sulle condizioni iniziali e sulle leggi fisiche coinvolte. Questa casualità è una caratteristica costitutiva del sistema.

Nel framework bayesiano, tuttavia, anche quella che classicamente viene considerata “incertezza ontologica” viene trattata come incertezza epistemica: poiché non abbiamo accesso completo allo stato del sistema, siamo costretti a quantificare la nostra ignoranza attraverso probabilità. Come osservò Laplace, per una mente onnisciente che conoscesse tutte le forze della natura e la posizione di ogni particella, il futuro sarebbe tanto determinato quanto il passato. La probabilità, dunque, non è una proprietà del mondo, ma emerge necessariamente dai limiti della nostra conoscenza.

1.3 Probabilità come grado di credenza

1.3.1 La visione bayesiana soggettivista

Nel paradigma bayesiano, assegnare una probabilità a un evento significa esprimere un grado di fiducia razionale nel verificarsi di quell’evento, basandosi su tutto ciò che si conosce in un dato momento. Questo approccio, sviluppato da Bruno de Finetti, Frank Ramsey e altri pensatori, concepisce la probabilità come fondamentalmente soggettiva, ma non per questo arbitraria.

Probabilità = grado di credenza (plausibilità) assegnato a un’affermazione, in base allo stato dell’informazione.

La definizione si articola attorno a quattro dimensioni fondamentali. La soggettività riconosce che individui diversi, con conoscenze ed esperienze diverse, possono ragionevolmente attribuire probabilità diverse allo stesso evento. Tuttavia, questa soggettività è vincolata dalla razionalità, che impone alle assegnazioni di probabilità di rispettare precisi principi di coerenza logica, come formalizzato negli assiomi della probabilità. Ogni valutazione è inoltre intrinsecamente condizionata dall’insieme di informazioni disponibili al momento della stima. Infine, il quadro è aggiornabile in modo sistematico: quando emergono nuove evidenze, le probabilità possono essere riviste coerentemente tramite il meccanismo dell’aggiornamento bayesiano.

Questa prospettiva trasforma la probabilità da una proprietà oggettiva del mondo a uno strumento logico per quantificare l’incertezza personale alla luce delle conoscenze disponibili.

1.4 L’argomento della coerenza: Dutch Book

Se la probabilità è soggettiva, come possiamo giustificare gli assiomi matematici che la governano? La risposta viene dall’argomento del Dutch Book, proposto da Bruno de Finetti.

1.4.1 Probabilità come scommessa equa

Bruno de Finetti propose un modo concreto e intuitivo per pensare alla probabilità: immaginala come la tua disposizione personale a scommettere su un evento.

1.4.1.1 Cosa significa nella pratica?

Quando affermi “La probabilità che piova domani è del 70%” \(P(pioggia) = 0.7\), secondo l’interpretazione di De Finetti, stai implicitamente dichiarando che:

considereresti equa la seguente scommessa:

- versi 0.70 euro per acquistare un “biglietto”;

- se domani piove, ricevi 1 euro come vincita;

- se domani non piove, non ricevi nulla.

…saresti quindi indifferente tra accettare o rifiutare questa scommessa. La ritieni perfettamente bilanciata, né a tuo vantaggio né a tuo svantaggio, in linea con la tua valutazione personale delle probabilità.

1.4.1.2 Il linguaggio delle quote e delle scommesse

Nel contesto delle scommesse, la quota rappresenta il prezzo da pagare per acquisire il diritto a una vincita potenziale. Nell’esempio precedente, con una probabilità del 70% di pioggia, una quota di 0.7 indica che si investono 0.70 euro per ogni euro di vincita potenziale.

Se l’evento si verifica (piove), il tuo guadagno netto ammonta a 0.30 euro, ottenuti sottraendo l’investimento iniziale (0.70 €) dalla vincita (1 €). Al contrario, se l’evento non si verifica (non piove), si subisce una perdita totale dell’investimento iniziale di 0.70 euro.

Questa struttura rende evidente come la probabilità soggettiva si traduca, dal punto di vista operativo, in una valutazione economica del rischio.

1.4.1.3 Perché proprio 0.70 è il prezzo equo?

Per comprendere perché 0.70 euro costituisca il prezzo equo in questo contesto, consideriamo cosa accadrebbe se questa stessa scommessa venisse ripetuta numerose volte in condizioni analoghe. Nel 70% dei casi, quando piove effettivamente, si realizza un guadagno netto di 0.30 euro. Nel restante 30% dei casi, caratterizzati dall’assenza di pioggia, si subirebbe una perdita di 0.70 euro. Se estendiamo questo scenario a un numero elevato di replicazioni, guadagni e perdite si compensano a vicenda, confermando l’equità della quota proposta.

Questa intuizione trova una formalizzazione matematica nell’espressione:

Prezzo equo = Probabilità × Vincita + (1 - Probabilità) × PerditaApplicando la formula al nostro esempio:

Prezzo equo = 0.7 × 1 euro + 0.3 × 0 euro = 0.70 euroIn termini più rigorosi, questa espressione corrisponde al concetto statistico di valore atteso, rappresentabile come:

\[ \text{Prezzo equo} = P(\text{pioggia}) \times 1 + [1 - P(\text{pioggia})] \times 0 = P(\text{pioggia}) \]

Possiamo quindi concludere che la probabilità soggettiva assegnata a un evento coincide con il prezzo massimo che si sarebbe disposti a pagare per ricevere 1 euro in caso di realizzazione dell’evento stesso.

1.4.2 Il Dutch Book: quando le nostre credenze ci portano alla rovina

Immaginate di essere così sicuri delle vostre credenze da essere disposti a scommetterci dei soldi. Cosa succederebbe se queste credenze fossero incoerenti tra loro? Un Dutch Book è proprio questo: una serie di scommesse che, se accettate, garantiscono una perdita matematicamente certa, qualunque cosa accada nella realtà.

Questo concetto ci mostra che gli assiomi della probabilità non sono convenzioni arbitrarie, ma requisiti fondamentali per pensare in modo razionale sull’incertezza.

1.4.3 Gli assiomi di Kolmogorov come vincoli di coerenza

Gli assiomi di Kolmogorov non sono leggi naturali, ma requisiti minimi per evitare contraddizioni:

Non negatività: \(0 \le P(A) \le 1\).

Un grado di credenza non può essere negativo né superare la certezza assoluta.Normalizzazione: \(P(\Omega) = 1\).

Siamo certi del fatto che almeno uno degli eventi possibili si verificherà.-

Additività: Per eventi mutualmente esclusivi \(A \cap B = \varnothing\),

\[P(A \cup B) = P(A) + P(B).\]La fiducia riposta nel verificarsi di \(A\) oppure \(B\) deve corrispondere alla somma delle fiducie assegnate ai due eventi considerati separatamente.

Nel loro insieme, questi principi assicurano che il nostro sistema di credenze sia internamente coerente e ci proteggano dal rischio di strategie di scommessa che garantirebbero perdite certe (Dutch Book).

1.5 Verifica della coerenza con R

Possiamo utilizzare R per verificare sistematicamente la coerenza di un’assegnazione di probabilità.

1.5.1 Esempio 1: verifica di coerenza per eventi mutualmente esclusivi

#> Somma delle probabilità assegnate: 1.2

#> ❌ INCOERENZA: la somma supera 1 per eventi mutualmente esclusivi.

#> Violazione dell'assioma di additività.

#> Esposizione al Dutch Book: perdita certa possibile!1.5.2 Esempio 2: simulazione di scommessa con prezzo equo

Simuliamo una scommessa su un evento \(A\) a cui assegniamo \(P(A) = 0.7\), verificando la coerenza attraverso il valore atteso.

#> ANALISI PREZZO COERENTE (0.7):

#> Valore atteso del payoff: 0.0009

#> Deviazione standard: 0.458

#> Interpretazione: valore atteso vicino a zero → scommessa equaOra testiamo un prezzo incoerente (0.9 per un evento a cui assegniamo probabilità 0.7):

# Scommessa con prezzo incoerente

unfair_price <- 0.9

payoff_unfair <- A_occurs * 1 - unfair_price#> ANALISI PREZZO INCOERENTE (0.9):

#> Valore atteso del payoff: -0.199

#> Perdita attesa per scommessa: 0.199

#> Interpretazione: valore atteso negativo → sovrapagamento sistematicoInterpretazione dei risultati: se il prezzo della scommessa coincide con la nostra credenza probabilistica (0.7), il valore atteso del payoff è circa zero, il che indica una scommessa equa. Al contrario, un prezzo superiore alla nostra credenza (0.9) genera un valore atteso negativo, indicando che stiamo pagando un prezzo eccessivo per l’evento rispetto alla nostra stessa valutazione della probabilità.

1.6 Cenni storici: la tradizione bayesiana

La teoria della probabilità affonda le sue radici nel XVII secolo con i lavori di Pascal e Fermat sui giochi d’azzardo. Tuttavia, l’interpretazione bayesiana si sviluppò in una tradizione parallela.

1.6.1 Thomas Bayes (1701-1761)

Il reverendo Thomas Bayes sviluppò quello che oggi chiamiamo teorema di Bayes, pubblicato postumo nel 1763. Il suo contributo fondamentale fu quello di riconoscere che è possibile invertire il ragionamento probabilistico: a partire da osservazioni, è possibile aggiornare razionalmente le proprie credenze su cause o parametri non osservati.

1.6.2 Pierre-Simon Laplace (1749-1827)

Laplace sviluppò e generalizzò il lavoro di Bayes applicando l’inferenza probabilistica ai problemi scientifici. La sua concezione della probabilità come “buon senso ridotto a calcolo” anticipò la moderna interpretazione epistemologica.

“La probabilità è relativa in parte all’ignoranza, in parte alla conoscenza.”

– Pierre-Simon Laplace

1.6.3 Bruno de Finetti (1906-1985)

De Finetti gettò le basi della moderna filosofia della probabilità bayesiana soggettivista. La sua famosa affermazione “la probabilità non esiste” significa che la probabilità non è una proprietà del mondo, ma uno strumento per quantificare l’incertezza.

Sviluppò l’argomento del Dutch Book e il concetto di scambiabilità, dimostrando che molti risultati classici (come la legge dei grandi numeri) possono essere derivati senza assumere probabilità “oggettive”.

1.6.4 Harold Jeffreys (1891-1989)

Nel suo influente Theory of Probability (1939), Jeffreys propose un approccio “oggettivo” bayesiano, basato su prior non informativi e principi di invarianza. Dimostrò l’utilità dell’inferenza bayesiana in geofisica e in altre scienze.

1.6.5 La rinascita moderna

Dopo un periodo di eclissi dovuto al dominio della statistica frequentista (Fisher, Neyman-Pearson), l’approccio bayesiano ha conosciuto una rinascita negli anni ’90 grazie:

- alla potenza computazionale (MCMC, Stan, JAGS);

- a nuovi testi divulgativi (Gelman, McElreath, Kruschke);

- all’applicazione in machine learning e AI.

1.7 Il ruolo delle simulazioni: illustrazione, non definizione

Una differenza cruciale rispetto all’approccio classico è il ruolo delle simulazioni e della Legge dei Grandi Numeri (LLN).

1.7.1 L’approccio frequentista classico (e i suoi limiti)

Nella prospettiva frequentista classica, la probabilità di un evento è definita dal suo comportamento asintotico in un numero molto elevato di prove ripetute:

\[ P(A) = \lim_{n \to \infty} \frac{\text{frequenza di occorrenza di A}}{n}. \]

La Legge dei Grandi Numeri garantisce che, in condizioni ideali, le frequenze relative osservate convergano effettivamente verso questo valore limite. Questo approccio implica tre assunzioni fondamentali:

- Oggettività: la probabilità è considerata una proprietà intrinseca del fenomeno, indipendente dall’osservatore;

- Misurabilità: le simulazioni e gli esperimenti servono a “scoprire” o stimare questa probabilità preesistente;

- Definizione operativa: la probabilità è definita attraverso il suo metodo di misurazione (la frequenza limite).

Tuttavia, questa prospettiva presenta diverse criticità quando viene applicata ai contesti decisionali reali:

- risulta problematica per gli eventi non ripetibili (es. “probabilità che domani piova”);

- presuppone l’esistenza di un limite che, nella pratica, non è mai osservabile;

- non fornisce un framework per quantificare l’incertezza in situazioni singole o uniche.

1.7.2 L’approccio bayesiano

Nella prospettiva bayesiana, la probabilità rappresenta un grado di credenza razionale riguardo al verificarsi di un evento, basato sulle informazioni disponibili. Questo approccio si basa su tre principi fondamentali:

- la probabilità come credenza: le assegnazioni probabilistiche esprimono il nostro stato di informazione e incertezza prima di osservare i dati;

- verifica della coerenza: le simulazioni servono a confermare che credenze iniziali coerenti si traducono in comportamenti attesi delle frequenze empiriche;

- convergenza esplicativa: la Legge dei Grandi Numeri spiega perché le frequenze osservate tendono a coincidere con le nostre credenze, ma non definisce cosa sia la probabilità.

In questo framework, la probabilità non è una proprietà da “scoprire” nel mondo, ma uno strumento logico per quantificare sistematicamente l’incertezza e aggiornare coerentemente le nostre convinzioni alla luce di nuove evidenze.

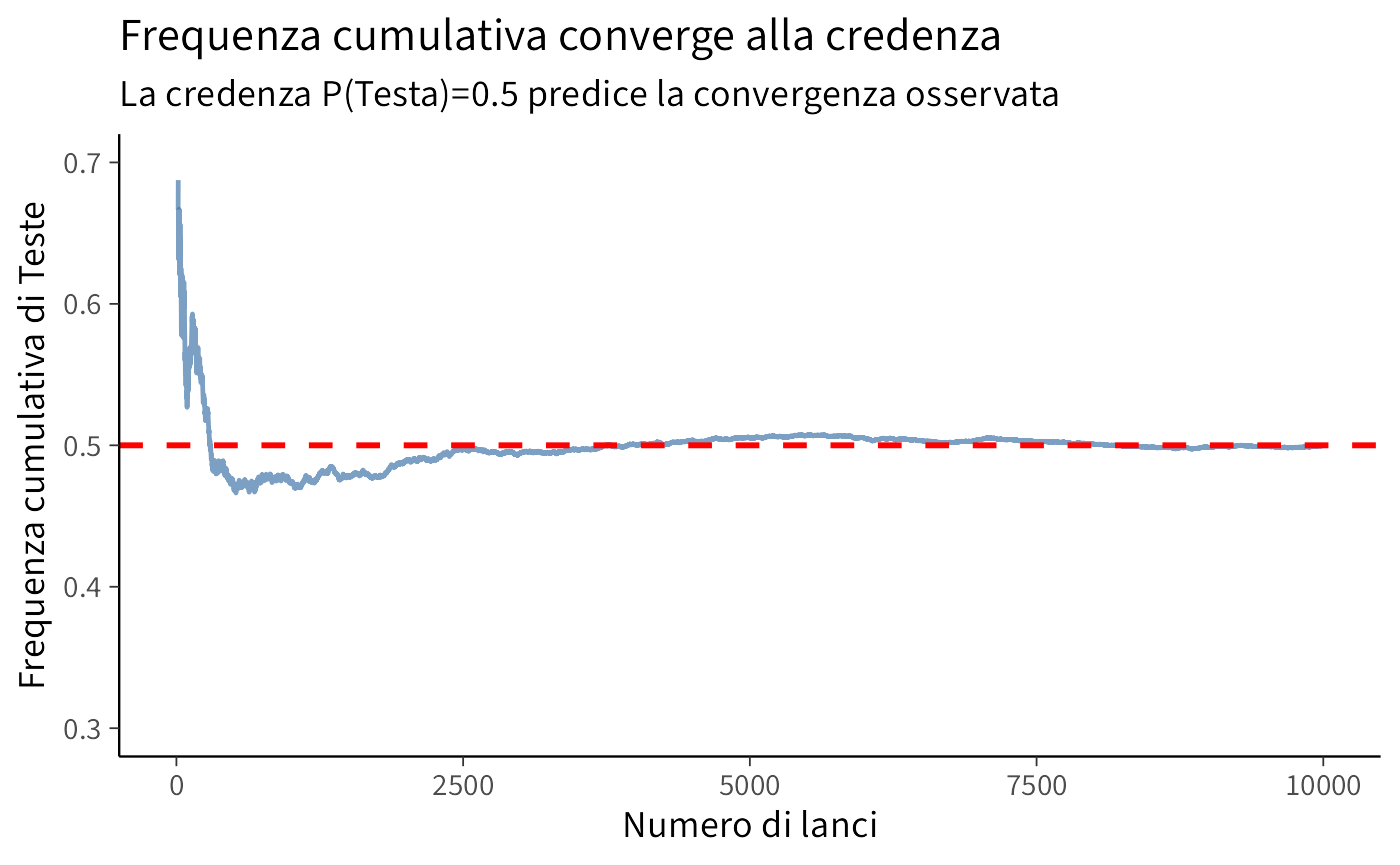

1.7.3 Simulazione come verifica di coerenza

Le simulazioni servono principalmente a convalidare che un sistema di credenze coerente genera comportamenti empirici attesi. Il loro ruolo è quello di illustrare concetti fondamentali come la convergenza statistica e la variabilità campionaria, nonché di confrontare le previsioni dei modelli probabilistici con i dati osservati.

È importante sottolineare che le simulazioni non definiscono la natura della probabilità, ma piuttosto verificano le implicazioni delle nostre assegnazioni probabilistiche, dimostrando come credenze razionali si traducano in regolarità osservabili.

1.7.4 Esempio: Lancio di moneta rivisitato

set.seed(42)

# Assegno credenza P(Testa) = 0.5 per simmetria epistemica

p_testa_credenza <- 0.5

# Simulazione: verifico che questa credenza è coerente

n_lanci <- 10000

risultati <- rbinom(n_lanci, 1, p_testa_credenza)

# Frequenza cumulativa

freq_cumulativa <- cumsum(risultati) / seq_along(risultati)

# Grafico

df <- data.frame(

lancio = seq_along(risultati),

freq = freq_cumulativa

)

ggplot(df, aes(x = lancio, y = freq)) +

geom_line(alpha = 0.7) +

geom_hline(yintercept = p_testa_credenza,

linetype = "dashed", color = "red", size = 1) +

labs(

title = "Frequenza cumulativa converge alla credenza",

subtitle = "La credenza P(Testa)=0.5 predice la convergenza osservata",

x = "Numero di lanci",

y = "Frequenza cumulativa di Teste"

) +

ylim(0.3, 0.7)

Interpretazione bayesiana: Abbiamo assegnato \(P(\text{Testa}) = 0.5\) per simmetria epistemica (nessuna ragione per favorire testa o croce). La simulazione verifica che questa credenza è coerente con la LLN: le frequenze convergono al valore atteso. Ma la probabilità 0.5 non è definita dalla convergenza—è stata assegnata prima, e la convergenza la conferma.

1.8 Prima introduzione all’aggiornamento bayesiano

1.8.1 Teorema di Bayes: dal concetto al test diagnostico

Il teorema di Bayes descrive come aggiornare una credenza iniziale \(P(H)\) sull’ipotesi \(H\) alla luce di una nuova evidenza \(E\):

\[ P(H \mid E) = \frac{P(E \mid H) , P(H)}{P(E)}. \]

Significato dei termini:

| Simbolo | Nome | Interpretazione generale |

|---|---|---|

| \(P(H)\) | prior | Credenza iniziale nell’ipotesi |

| \(P(E \mid H)\) | verosimiglianza | Quanto è probabile osservare \(E\) se \(H\) è vera |

| \(P(E)\) | evidenza | Probabilità complessiva di osservare \(E\) |

| \(P(H \mid E)\) | posterior | Credenza aggiornata in \(H\) dopo aver visto \(E\) |

1.8.1.1 Applicazione: il test diagnostico

Nel caso di un test medico, la struttura è identica, ma i simboli assumono un significato concreto:

| Formula generale | Corrispondenza nel test diagnostico |

|---|---|

| \(H\) | “Il paziente ha la malattia” (\(D\)) |

| \(\neg H\) | “Il paziente non ha la malattia” (\(\neg D\)) |

| \(E\) | “Il test è positivo” (\(+\)) |

| \(P(H)\) | \(P(D)\): prevalenza (probabilità a priori di essere malato) |

| \(P(E \mid H)\) | \(P(+ \mid D)\): sensibilità |

| \(P(E \mid \neg H)\) | \(P(+ \mid \neg D)\): tasso di falsi positivi |

| \(P(H \mid E)\) | \(P(D \mid +)\): probabilità di essere malato dopo un test positivo |

Usando la notazione precedente, la formula di Bayes diventa:

\[ P(D \mid +) = \frac{P(+ \mid D) \, P(D)} {P(+ \mid D) \, P(D) + P(+ \mid \neg D) \, P(\neg D)}. \]

1.8.2 Esempio numerico

Supponiamo che:

- la prevalenza della condizione sia \(P(D\) = 0.10);

- la sensibilità del test sia \(P(+ \mid D\) = 0.80);

- la specificità sia \(P(- \mid \neg D) = 0.90\), quindi \(P(+ \mid \neg D) = 0.10\).

Vogliamo sapere: dopo un test positivo, qual è la probabilità di avere la malattia?

# Parametri del test

p_D <- 0.10 # Prevalenza = prior P(D)

sens <- 0.80 # Sensibilità = P(+ | D)

spec <- 0.90 # Specificità = P(- | ~D)

p_pos_given_notD <- 1 - spec # Falsi positivi P(+ | ~D)

# Probabilità complessiva di test positivo

p_pos <- sens * p_D + p_pos_given_notD * (1 - p_D)

# Teorema di Bayes: posterior

p_D_given_pos <- (sens * p_D) / p_pos

cat("P(D) =", p_D, "\n")

#> P(D) = 0.1

cat("P(D | +) =", round(p_D_given_pos, 3), "\n")

#> P(D | +) = 0.4711.8.3 Interpretazione passo per passo

- Prima del test: credenza iniziale = prevalenza = 10%.

- Dopo un test positivo: la credenza aggiornata sale a 47%.

- Nonostante la buona sensibilità e specificità, resta una forte incertezza: su 100 test positivi, circa 53 sono falsi positivi.

1.8.4 Riepilogo concettuale

\[ \underbrace{P(D)}_{\text{prior}} \quad \xrightarrow[\text{aggiornamento con } P(+|D), P(+|\neg D)]{\text{osservazione del test positivo}} \quad \underbrace{P(D \mid +)}_{\text{posterior}} \]

Il teorema di Bayes mostra che la probabilità finale non dipende solo dalla qualità del test, ma anche da quanto la malattia era plausibile a priori. In termini psicologici, è il modello formale del ragionamento inferenziale: integrare l’informazione nuova con le conoscenze precedenti in modo coerente.

1.8.4.1 Visualizzazione con una tabella di contingenza

Per rendere concreto il ragionamento, immaginiamo una popolazione di 1000 persone.

- Il 10% (cioè 100 persone) ha la malattia.

- L’80% di queste (80 persone) risulterà positivo: veri positivi.

- Il 90% delle persone sane (900 persone) risulterà negativo, quindi il 10% (90 persone) darà un falso positivo.

| Stato reale / Esito del test | Positivo | Negativo | Totale |

|---|---|---|---|

| Malato \(D\) | 80 | 20 | 100 |

| Sano \(¬D\) | 90 | 810 | 900 |

| Totale | 170 | 830 | 1000 |

Tra i 170 test positivi, solo 80 appartengono a persone realmente malate.

\[ P(D \mid +) = \frac{80}{170} \approx 0.47. \]

Lo stesso valore ottenuto con la formula di Bayes.

1.8.5 Codice R per la simulazione e la tabella

# Parametri del test

p_D <- 0.10 # Prevalenza = prior P(D)

sens <- 0.80 # Sensibilità = P(+ | D)

spec <- 0.90 # Specificità = P(- | ~D)

p_pos_given_notD <- 1 - spec # Falsi positivi P(+ | ~D)

# Calcolo per 1000 persone

N <- 1000

malati <- N * p_D

sani <- N * (1 - p_D)

veri_positivi <- malati * sens

falsi_negativi <- malati * (1 - sens)

falsi_positivi <- sani * p_pos_given_notD

veri_negativi <- sani * spec

tabella <- data.frame(

`Stato reale` = c("Malato (D)", "Sano (¬D)", "Totale"),

`Positivo` = c(veri_positivi, falsi_positivi, veri_positivi + falsi_positivi),

`Negativo` = c(falsi_negativi, veri_negativi, falsi_negativi + veri_negativi),

`Totale` = c(malati, sani, N)

)

tabella

#> Stato.reale Positivo Negativo Totale

#> 1 Malato (D) 80 20 100

#> 2 Sano (¬D) 90 810 900

#> 3 Totale 170 830 10001.8.6 Interpretazione visiva

La tabella mostra da dove viene il 47%:

- su 170 test positivi, 80 sono veri positivi e 90 falsi positivi;

- quindi, anche con un test buono, la maggioranza dei positivi può risultare non malata se la prevalenza è bassa.

1.8.7 Sintesi concettuale

| Quantità | Formula | Valore | Significato |

|---|---|---|---|

| \(P(D)\) | 0.10 | Prevalenza (prior) | |

| \(P(+ \mid D)\) | 0.80 | Sensibilità | |

| \(P(+ \mid \neg D)\) | 0.10 | Falsi positivi | |

| \(P(D \mid +)\) | 0.47 | Probabilità aggiornata (posterior) |

Conclusione: Il teorema di Bayes ci permette di passare dal livello astratto delle probabilità condizionate alla rappresentazione concreta delle frequenze. Questa doppia lettura – formale e intuitiva – è ciò che rende Bayes uno strumento potente per comprendere come la mente (o un sistema razionale) aggiorna le credenze alla luce di nuove evidenze.

Questa è l’essenza del ragionamento bayesiano: aggiornamento sistematico e razionale delle credenze alla luce di nuove evidenze.

1.9 Il ruolo della probabilità nello studio dei fenomeni psicologici

La teoria della probabilità bayesiana fornisce un framework particolarmente adatto alla psicologia, offrendo strumenti concettuali e metodologici che rispondono alle esigenze specifiche della ricerca e della pratica clinica in questo campo.

1.9.1 Quantificare l’incertezza diagnostica

Nella pratica clinica, infatti, è raro disporre di certezze assolute. Un clinico che valuta un paziente deve integrare informazioni provenienti da fonti diverse, come l’anamnesi, l’osservazione comportamentale e i test psicometrici, ciascuna delle quali porta con sé un certo grado di incertezza. La probabilità bayesiana permette di quantificare esplicitamente l’incertezza delle diagnosi, fornendo un linguaggio matematico per esprimere il livello di fiducia in un’ipotesi diagnostica. Attraverso il teorema di Bayes, è possibile integrare in modo sistematico le informazioni provenienti da test multipli, ciascuno dei quali modifica le nostre credenze in modo coerente e trasparente. Particolarmente rilevante è la possibilità di considerare esplicitamente la prevalenza dei disturbi nella popolazione di riferimento, ovvero il cosiddetto “prior”, evitando errori diagnostici derivanti dall’ignorare i tassi base. Questo approccio consente inoltre di comunicare l’incertezza in modo chiaro e onesto sia ai colleghi sia ai pazienti, riconoscendo i limiti della conoscenza diagnostica senza rinunciare a quantificarla in modo rigoroso.

1.9.2 Modellare processi cognitivi

Un’area di ricerca sempre più influente suggerisce che la mente umana funzioni secondo principi fondamentalmente bayesiani. Nella percezione, ad esempio, il cervello sembra integrare costantemente le aspettative pregresse, basate su esperienze passate e regolarità ambientali, con l’input sensoriale del momento, proprio come farebbe un osservatore bayesiano ideale che combina prior e verosimiglianza. Questo framework spiega fenomeni come le illusioni percettive, in cui aspettative forti possono prevalere su segnali sensoriali deboli o ambigui. Anche l’apprendimento può essere concepito come un processo di aggiornamento bayesiano delle credenze attraverso l’esperienza: ogni nuova osservazione modifica la nostra comprensione del mondo in proporzione alla sua capacità di fornire informazioni. Nei processi decisionali, infine, il framework bayesiano offre un modello normativo su come dovremmo bilanciare evidenze incerte e obiettivi multipli. È interessante notare che molti bias cognitivi documentati nella letteratura psicologica, come l’effetto di ancoraggio o la conservatività nell’aggiornamento delle credenze, possono essere interpretati come deviazioni sistematiche dall’ottimalità bayesiana, fornendo ipotesi testabili sui meccanismi alla base del ragionamento umano.

1.9.3 Analizzare dati sperimentali

Dal punto di vista metodologico, l’inferenza bayesiana offre notevoli vantaggi per l’analisi dei dati psicologici. A differenza dell’approccio frequentista tradizionale, il framework bayesiano permette di incorporare formalmente le conoscenze pregresse derivanti da studi pilota, dalla letteratura esistente o da teorie consolidate, traducendole in distribuzioni a priori che guidano l’interpretazione dei nuovi dati. Questo è particolarmente prezioso in psicologia, dove raramente si parte da zero nella formulazione delle ipotesi. Un altro vantaggio cruciale riguarda la possibilità di quantificare l’evidenza a favore dell’ipotesi nulla, superando una limitazione fondamentale del valore-\(p\) che può solo rigettare, ma non confermare, l’assenza di un effetto. Inoltre, l’approccio bayesiano gestisce naturalmente i piccoli campioni, comuni nella ricerca clinica e in alcuni ambiti sperimentali, senza richiedere le approssimazioni asintotiche su cui si basano molti test frequentisti. Infine, nei modelli statistici complessi che caratterizzano sempre più la ricerca psicologica contemporanea, il framework bayesiano consente di propagare l’incertezza in modo coerente e sistematico attraverso tutti i livelli del modello, fornendo stime dell’incertezza più realistiche e informative.

1.9.4 Decisioni cliniche

In ambito terapeutico, l’approccio bayesiano fornisce strumenti utili per la pratica quotidiana. Quando valutiamo l’efficacia di trattamenti personalizzati, possiamo partire da evidenze generali sulla popolazione e aggiornarle progressivamente con le risposte specifiche del singolo paziente, ottenendo così una stima sempre più precisa dell’efficacia terapeutica per quella persona in particolare. Questo processo iterativo di aggiornamento consente anche di modificare i protocolli terapeutici man mano che emergono nuove evidenze, sia dalla letteratura che dall’esperienza clinica diretta, senza dover attendere la conclusione di revisioni sistematiche complete. Nelle decisioni che implicano rischi e benefici, come la scelta tra diverse opzioni farmacologiche o l’intensità di un intervento, il framework bayesiano fornisce strumenti formali per bilanciare probabilità e utilità in condizioni di incertezza, rendendo espliciti i trade-off impliciti in ogni decisione clinica. Quando si tratta di pianificare sequenze di interventi, in cui le decisioni successive dipendono dai risultati precedenti, l’aggiornamento bayesiano fornisce una guida naturale per ottimizzare il percorso terapeutico in modo adattivo e basato sull’evidenza.

1.10 Confronto con l’approccio frequentista

Per apprezzare appieno la prospettiva bayesiana, è utile chiarire le differenze fondamentali rispetto all’approccio frequentista, che ancora oggi domina gran parte della formazione statistica in psicologia. Le due scuole di pensiero divergono già dalla definizione stessa di probabilità. Secondo l’approccio frequentista, la probabilità è concepita come la frequenza limite di un evento in infinite repliche ipotetiche di un esperimento, mentre secondo l’approccio bayesiano rappresenta il grado di credenza razionale in base al nostro stato di informazione. Questa differenza filosofica ha profonde implicazioni pratiche.

Nel paradigma frequentista, i parametri di interesse, come la media di una popolazione o l’effetto di un trattamento, sono considerati quantità fisse, ma ignote, su cui non è possibile fare affermazioni probabilistiche dirette. Possiamo solo parlare delle proprietà delle procedure che utilizziamo per stimarle. Al contrario, nell’approccio bayesiano, i parametri sono trattati come variabili casuali caratterizzate da distribuzioni di probabilità che esprimono direttamente il nostro livello di incertezza riguardo a essi. Ciò consente di formulare affermazioni come “la probabilità che l’effetto del trattamento sia positivo è 0.85”, cosa impossibile da fare rigorosamente nel quadro frequentista.

L’inferenza stessa è concepita in modo diverso nei due paradigmi. L’approccio frequentista valuta le proprietà di procedure ripetute: un intervallo di confidenza al 95%, per esempio, è costruito in modo tale che, se si replicasse infinite volte lo stesso esperimento, il 95% degli intervalli così costruiti conterrebbe il valore effettivo del parametro. Tuttavia, questo non ci dice nulla sulla probabilità che un intervallo specifico, costruito sulla base dei dati osservati, contenga il parametro. L’approccio bayesiano, invece, produce intervalli di credibilità che hanno un’interpretazione probabilistica diretta: un intervallo al 95% contiene il parametro con probabilità 0.95, dati i risultati osservati.

Una distinzione cruciale riguarda il ruolo delle conoscenze pregresse. Nel framework frequentista non esiste un meccanismo formale che permetta di incorporare informazioni pregresse all’analisi dei dati correnti. L’approccio bayesiano, invece, considera le conoscenze pregresse, codificate nelle distribuzioni a priori, come un elemento essenziale e trasparente del processo inferenziale. Questo aspetto può essere considerato un vantaggio, in quanto rende esplicito ciò che, nella pratica, influenza comunque le nostre conclusioni, oppure una fonte di soggettività, a seconda della prospettiva.

Anche gli strumenti inferenziali differiscono sostanzialmente. Il p-value, pilastro dell’inferenza frequentista, quantifica la probabilità di osservare dati estremi quanto o più dei nostri, a condizione che l’ipotesi nulla sia vera. Si tratta di una probabilità condizionale che risponde alla domanda: “Quanto sarebbero sorprendenti questi dati se l’ipotesi nulla fosse vera?”. Tuttavia, questa non è la domanda che ci poniamo di solito: ci interessa piuttosto sapere quanto sia plausibile l’ipotesi nulla alla luce di questi dati. Una domanda a cui solo l’approccio bayesiano può rispondere direttamente. L’interpretazione bayesiana permette infatti di calcolare le probabilità a posteriori delle ipotesi, fornendo risposte più intuitive e direttamente rilevanti per le decisioni di natura scientifica e clinica.

Riflessioni conclusive

In questo capitolo, abbandoniamo la concezione della probabilità come semplice “frequenza relativa” per abbracciarne una più potente e generale: la probabilità come “grado di credenza razionale”. Questa prospettiva, radicata nella tradizione di Bayes, Laplace e De Finetti, non è solo un tecnicismo matematico, ma una lente attraverso cui interpretare il ragionamento umano in situazioni di incertezza. Perché è così rilevante per la psicologia?

Questa impostazione epistemica offre cinque vantaggi fondamentali:

Fondazione logica, non empirica: gli assiomi della probabilità diventano vincoli di coerenza logica per le nostre convinzioni. Non si tratta di leggi naturali da verificare sperimentalmente, ma di principi di razionalità che, se violati, portano a contraddizioni.

Massima generalità: possiamo quantificare l’incertezza relativa a eventi unici e non ripetibili; Domande come “Questo specifico paziente guarirà?” o “Questa teoria è vera?” trovano una risposta formale senza bisogno di un ipotetico esperimento ripetuto all’infinito.

Completa trasparenza: tutte le nostre assunzioni iniziali (le probabilità a priori) sono esplicite e messe in discussione. Questo favorisce un dialogo scientifico più rigoroso, in cui non ci si nasconde dietro un’illusoria “oggettività”.

Apprendimento dinamico: il teorema di Bayes formalizza matematicamente il processo di apprendimento dall’esperienza. Esso mostra come le nostre credenze si evolvono e si affinano man mano che raccogliamo nuovi dati.

Aderenza al ragionamento umano: questo approccio rispecchia in modo più fedele il modo in cui la nostra mente valuta i rischi e prende decisioni in condizioni di informazione incompleta.

Nei prossimi capitoli costruiremo gli strumenti formali di questo quadro teorico, dagli assiomi al concetto fondamentale di probabilità condizionata, restando sempre fedeli a questa prospettiva. Scopriremo, ad esempio, che nozioni come l’equiprobabilità non sono proprietà intrinseche del mondo, ma riflettono una simmetria nelle nostre informazioni.

La probabilità bayesiana non elimina l’incertezza, ma la quantifica e la gestisce razionalmente. È questo il suo grande valore per la ricerca psicologica, dove l’incertezza è la norma, non l’eccezione.