4 Probabilità condizionata

“Probability is always conditional.”

– Dennis V. Lindley, The Philosophy of Statistics (2000).

Introduzione

La probabilità condizionata esprime la probabilità di un evento in relazione al verificarsi di un altro evento. Questo concetto è fondamentale, in quanto riflette il modo in cui aggiorniamo le nostre credenze alla luce di nuove informazioni. Ad esempio, la probabilità che piova domani può variare in base alle condizioni atmosferiche odierne: osservare un cielo nuvoloso può influenzare la nostra valutazione della probabilità di pioggia. In questo senso, ogni nuova informazione può confermare, rafforzare o mettere in discussione le credenze preesistenti.

La probabilità condizionata riveste un ruolo centrale non solo nella teoria della probabilità, ma anche nelle applicazioni quotidiane e scientifiche. In molti contesti, le probabilità sono implicitamente condizionate da informazioni preesistenti, anche se non le esplicitiamo formalmente. Comprendere e quantificare questo processo di aggiornamento delle credenze ci permette di gestire l’incertezza in modo più efficace, trasformando la probabilità in uno strumento dinamico per la presa di decisioni e l’inferenza.

Panoramica del capitolo

- Concetti di probabilità congiunta, marginale e condizionata.

- Applicazione dei principi di indipendenza e probabilità condizionata.

- Il paradosso di Simpson;

- Il teorema del prodotto e della probabilità totale.

4.1 Indipendenza stocastica

In alcuni casi, l’aggiornamento delle probabilità diventa particolarmente semplice. Ciò si verifica quando due eventi non si influenzano a vicenda. In tali situazioni, la probabilità che essi si verifichino insieme può essere calcolata direttamente, grazie alla proprietà di indipendenza.

4.1.1 Indipendenza di due eventi

Definizione 4.1 Due eventi \(A\) e \(B\) si dicono indipendenti se la probabilità che si verifichino entrambi è pari al prodotto delle loro probabilità individuali:

\[ P(A \cap B) = P(A) \, P(B). \tag{4.1}\]

Ciò significa che conoscere l’esito di uno dei due eventi non fornisce alcuna informazione utile sull’altro. In simboli, si scrive \(A \perp B\) per indicare che \(A\) e \(B\) sono eventi indipendenti.

4.2 Indipendenza di un insieme di eventi

Il concetto di indipendenza non riguarda soltanto due eventi, ma può estendersi anche a un insieme più ampio. In generale, diciamo che \({A_i : i \in I}\) è un insieme di eventi indipendente se, per ogni sottoinsieme finito \(J \subseteq I\), la probabilità che si verifichino contemporaneamente tutti gli eventi di \(J\) è uguale al prodotto delle loro probabilità individuali:

\[ P \Bigl(\bigcap_{i \in J} A_i\Bigr) \;=\; \prod_{i \in J} P(A_i). \tag{4.2}\] In altre parole, nessun evento della collezione fornisce informazioni utili sugli altri: il verificarsi di uno non modifica la probabilità degli altri.

Nella pratica, questa condizione è molto forte. Per questo motivo, l’indipendenza di più eventi può avere due significati distinti:

- può essere un’ipotesi semplificante in un modello (per esempio, assumere che le risposte a diverse domande di un questionario siano indipendenti, cioè non influenzate tra loro);

- può essere una proprietà empirica dei dati, che deve però essere verificata con analisi specifiche.

4.2.1 Quando gli eventi non sono indipendenti

Se per due eventi \(A\) e \(B\) vale la disuguaglianza

\[

P(A \cap B) \neq P(A) \cdot P(B),

\] allora essi non sono indipendenti. In tal caso, la conoscenza dell’esito di uno dei due eventi fornisce informazioni rilevanti sulla probabilità del verificarsi dell’altro. Questa dipendenza deve essere esplicitamente considerata nei calcoli probabilistici, ad esempio ricorrendo al concetto di probabilità condizionata.

4.3 Probabilità condizionata

La probabilità condizionata quantifica la probabilità che si verifichi un evento \(A\), dato che si è verificato un altro evento \(B\).

Definizione 4.2 Se \(P(B) > 0\), la probabilità condizionata di \(A\) dato \(B\) è definita come:

\[ P(A \mid B) = \frac{P(A \cap B)}{P(B)}. \tag{4.3}\]

Questa espressione può essere interpretata come un’operazione di confinamento probabilistico agli esiti in cui \(B\) si verifica, ricalibrando così la misura di probabilità sull’evento condizionante.

4.3.1 Interpretazione della probabilità condizionata

La probabilità condizionata rappresenta un meccanismo di aggiornamento delle nostre conoscenze. Inizialmente, si dispone di una probabilità \(P(A)\); dopo aver osservato il verificarsi di un evento correlato \(B\), si restringe lo spazio degli esiti possibili a quelli compatibili con \(B\), ricalibrando di conseguenza la probabilità di \(A\).

- Esempio intuitivo: Se una persona ha la febbre (\(B\)), la probabilità che abbia l’influenza (\(A\)) aumenta rispetto alla probabilità basata sulla sola popolazione generale.

Questa capacità di “aggiornare probabilisticamente” le credenze rende la probabilità condizionata uno strumento essenziale in:

-

diagnosi medica: per valutare la probabilità di una malattia (\(A\)) dato il risultato di un test (\(B\));

- previsioni meteorologiche, per stimare la probabilità di pioggia \(A\)) dato l’arrivo di un fronte nuvoloso (\(B\));

- modellizzazione delle dipendenze stocastiche, dove il verificarsi di un evento influisce sulla probabilità di un altro.

La formula \(P(A \mid B) = \frac{P(A \cap B)}{P(B)}\) quantifica proprio questo processo di revisione della probabilità alla luce di nuove informazioni.

4.4 Indipendenza e probabilità condizionata

Il concetto di indipendenza tra due eventi \(A\) e \(B\) può essere caratterizzato in modo intuitivo attraverso la lente della probabilità condizionata. Due eventi sono indipendenti se il verificarsi di uno non altera la probabilità del verificarsi dell’altro. In altre parole, la conoscenza dell’esito di \(B\) non fornisce alcuna informazione utile su \(A\), e viceversa.

Formalmente, questa condizione si esprime attraverso le relazioni:

\[ P(A \mid B) = \frac{P(A \cap B)}{P(B)} = P(A), \] \[ P(B \mid A) = \frac{P(A \cap B)}{P(A)} = P(B). \] Di conseguenza, \(A\) e \(B\) sono indipendenti se e solo se vale una delle seguenti condizioni equivalenti:

- \(P(A \mid B) = P(A)\),

- \(P(B \mid A) = P(B)\),

- \(P(A \cap B) = P(A) \cdot P(B)\). Questo implica che la probabilità di \(A\) rimane invariata sia che \(B\) si sia verificato o meno, e analogamente per \(B\). L’indipendenza stocastica rappresenta dunque l’assenza completa di influenza reciproca tra i due eventi.

4.4.1 Indipendenza di tre eventi

La definizione di indipendenza si generalizza a tre eventi \(A\), \(B\) e \(C\) richiedendo condizioni più stringenti rispetto al caso bivariato. Tre eventi si definiscono completamente indipendenti se:

Indipendenza a coppie: \[ \begin{aligned} P(A \cap B) &= P(A) P(B), \\ P(A \cap C) &= P(A) P(C), \\ P(B \cap C) &= P(B) P(C). \end{aligned} \]

Indipendenza dell’intersezione tripla: \[ P(A \cap B \cap C) = P(A) P(B) P(C). \]

Le prime tre condizioni garantiscono l’indipendenza tra ogni coppia di eventi, mentre la quarta condizione assicura che l’indipendenza sia valida anche per l’interazione simultanea dei tre eventi. È cruciale osservare che l’indipendenza a coppie non implica l’indipendenza completa: possono esistere esempi in cui le coppie sono indipendenti ma l’intersezione tripla non factorizza nel prodotto delle probabilità marginali.

In sintesi, l’indipendenza completa richiede che il verificarsi di qualsiasi sottoinsieme degli eventi non influenzi la probabilità degli altri. Questa proprietà semplifica notevolmente il calcolo delle probabilità congiunte ed è alla base di molti modelli probabilistici e statistici.

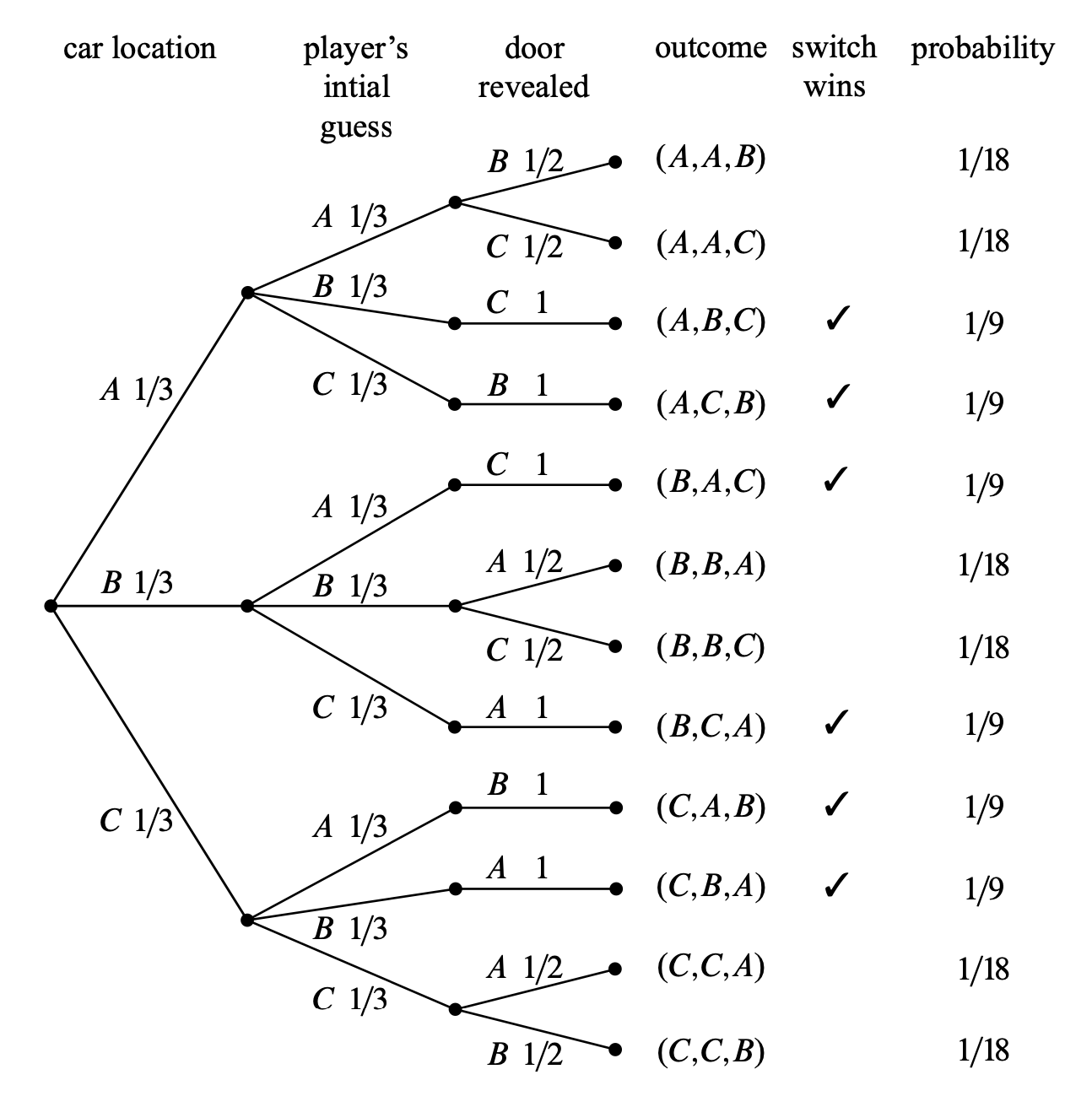

4.5 Teorema del prodotto

A partire dalla definizione di probabilità condizionata, si deriva il Teorema del Prodotto (noto anche come regola della catena o regola moltiplicativa). Questo teorema consente di esprimere la probabilità congiunta di due o più eventi come prodotto di probabilità condizionate.

4.5.1 Caso di due eventi

Per due eventi \(A\) e \(B\), il Teorema del Prodotto afferma che:

\[ P(A \cap B) = P(B) \cdot P(A \mid B) = P(A) \cdot P(B \mid A). \tag{4.4}\] In altre parole, la probabilità che \(A\) e \(B\) si verifichino simultaneamente può essere calcolata in due modi equivalenti:

- moltiplicando la probabilità di \(B\) per la probabilità di \(A\) dato \(B\);

- moltiplicando la probabilità di \(A\) per la probabilità di \(B\) dato \(A\).

La scelta dell’ordine dipende dalla disponibilità delle probabilità condizionate o dalla struttura del problema.

4.5.2 Generalizzazione a \(n\) eventi

Il teorema si estende a \(n\) eventi \(A_1, A_2, \dots, A_n\), assumendo che \(P(A_1 \cap A_2 \cap \cdots \cap A_{n-1}) > 0\). In tal caso:

\[ \begin{aligned} P(A_1 \cap A_2 \cap \cdots \cap A_n) = & \, P(A_1) \\ & \cdot P(A_2 \mid A_1) \\ & \cdot P(A_3 \mid A_1 \cap A_2) \\ & \, \vdots \\ & \cdot P(A_n \mid A_1 \cap A_2 \cap \cdots \cap A_{n-1}). \end{aligned} \tag{4.5}\] Ogni fattore rappresenta la probabilità di un evento condizionata al verificarsi di tutti gli eventi precedenti. Questa forma è particolarmente utile per modellare processi sequenziali o dipendenze condizionate.

4.5.2.1 Procedura di applicazione

- Inizia con la probabilità marginale del primo evento: \(P(A_1)\);

- Moltiplica progressivamente per le probabilità condizionate successive;

- Includi l’ultimo termine: \(P(A_n \mid A_1 \cap \cdots \cap A_{n-1})\).

In sintesi, il Teorema del Prodotto riveste un ruolo fondamentale in molteplici contesti applicativi e teorici. In particolare, esso costituisce uno strumento essenziale nella modellazione di processi stocastici sequenziali, dove consente di calcolare la probabilità congiunta di eventi concatenati esprimendola come prodotto di probabilità condizionate lungo la sequenza. Inoltre, il teorema permette la scomposizione di problemi complessi in fasi condizionate, facilitando così l’analisi di scenari multivariati attraverso un approccio graduale e gerarchico. Infine, trova un’applicazione cruciale nella costruzione di reti bayesiane e nell’inferenza probabilistica, dove viene utilizzato per rappresentare e calcolare efficientemente le dipendenze condizionali tra variabili aleatorie, fornendo una base formale per l’aggiornamento delle credenze alla luce di nuove evidenze.

4.6 Teorema della probabilità totale

Il Teorema della Probabilità Totale (noto anche come legge della probabilità totale) consente di calcolare la probabilità di un evento \(A\) scomponendolo rispetto a una partizione dello spazio campionario. Questo approccio è particolarmente utile quando si considerano scenari multipli, categorie distinte o gruppi che formano una suddivisione esaustiva di \(\Omega\).

4.6.1 Enunciato formale

Definizione 4.3 Sia \(\{B_1, B_2, \dots, B_n\}\) una partizione di \(\Omega\), cioè una collezione di eventi tali che:

- Mutua esclusività: \(B_i \cap B_j = \emptyset\) per ogni \(i \neq j\);

- Copertura completa: \(\bigcup_{i=1}^n B_i = \Omega\).

Allora, per qualsiasi evento \(A \subseteq \Omega\), vale:

\[ P(A) = \sum_{i=1}^n P(A \cap B_i) = \sum_{i=1}^n P(A \mid B_i) \cdot P(B_i). \tag{4.6}\] In pratica, \(P(A)\) è una media ponderata delle probabilità condizionate \(P(A \mid B_i)\), con pesi dati dalle probabilità \(P(B_i)\).

4.6.2 Caso particolare: partizione binaria

Quando la partizione è composta da due eventi complementari \(B\) e \(B^c\), la formula assume la forma semplificata:

\[ P(A) = P(A \mid B) \cdot P(B) + P(A \mid B^c) \cdot P(B^c). \tag{4.7}\]

4.6.3 Applicazioni

Analisi stratificata:

Utile quando la popolazione è suddivisa in sottogruppi (es. fasce d’età, regioni geografiche). La probabilità di \(A\) si calcola aggregando i contributi di ciascun gruppo.Teorema di Bayes:

Il denominatore nella formula di Bayes è un’applicazione diretta di questo teorema, dove le ipotesi \(H_1, \dots, H_n\) formano una partizione dello spazio delle ipotesi.Processi decisionali:

Consente di valutare la probabilità di un evento considerando tutti i possibili scenari o stati del mondo.

In sintesi, il teorema della probabilità totale permette di frammentare un problema complesso in componenti più gestibili, condizionate a elementi di una partizione, per poi ricombinarle in una soluzione completa.

Riflessioni conclusive

La probabilità condizionata è uno dei concetti più importanti in statistica, poiché fornisce il quadro teorico per:

- comprendere e formalizzare l’indipendenza tra eventi o variabili (assenza di ogni tipo di relazione);

- espandere e generalizzare il calcolo delle probabilità (ad esempio, la legge della probabilità totale, che scompone in modo sistematico eventi complessi);

- alimentare metodi inferenziali avanzati, come il Teorema di Bayes.

In particolare, il Teorema di Bayes rappresenta uno strumento cardine dell’inferenza statistica: grazie alla probabilità condizionata, è possibile “aggiornare” in modo continuo le credenze sulle ipotesi (o sui parametri di un modello) alla luce di nuove osservazioni. Tale caratteristica di “apprendimento” graduale rende l’inferenza bayesiana flessibile e potente, ideale per affrontare situazioni in cui vengono resi disponibili dati aggiuntivi o in cui le condizioni iniziali possono cambiare.

In definitiva, la probabilità condizionata non solo chiarisce la nozione di indipendenza e getta le fondamenta di metodi inferenziali evoluti, ma soprattutto rappresenta il “motore” di modelli che si adattano dinamicamente alle nuove informazioni. Questa prospettiva “attiva” nell’aggiornamento delle probabilità è ciò che rende l’analisi statistica uno strumento versatile per descrivere e interpretare il mondo reale.